作为一个非技术人员,为了更好的了解算力这个概念,我和ChatGPT做了一次深谈,以下内容是根据同事科普和AI的补充内容整理完成。

人们长期致力于提升算力能级和量级,不断制造更强大的处理器、存储器等计算设备来提升终端算力,也通过发展超级计算、云计算等技术来打造算力基地和算力平台,推动全球算力规模持续扩大。算力的发展史就是计算机的硬件发展史,这篇文章很适合作为计算机发展史的科普~欢迎指正。

算力简史

算力就是计算和处理数据的能力,从人类开始数学计算,算“1+1=2”的那一天就已经存在。从最早的算盘,到机械计算器到现在的高性能计算/超算中心等等,大概分了几个阶段:

早期的计算设备

算盘(约公元前2700年,古代中国)

被认为是最早的计算工具之一,主要用于简单的算术运算。

安提基特拉机械(约公元前100年,古希腊)

一个复杂的机械装置,用来预测天文位置和日食。(看起来还有点像咱们的罗盘呢)

巴斯卡尔计算机(1642年,法国)

布莱兹·巴斯卡尔发明的机械计算器,轮子分别代表着个、十、百、千、万、十万等单位,只需要拨动轮子就可以进行加减法,原理和手表很像。

莱布尼茨轮(1673年,德国)

由戈特弗里德·莱布尼茨改进,能进行加、减、乘、除及求平方根的计算,据说他用这个设备来计算人口。

核心是里面的一个圆柱机械设计,直到1948年以前,机械计算机的制造中都还在采用此类分级的圆柱体,如国际商用机器公司(IBM)所制造的手摇计算器。

电子计算机的诞生

ABC计算机(1937-1942年,美国)

约翰·阿塔纳索夫和克利福德·贝里构建的世界上第一台电子数字计算机,不可编程,仅仅设计用于求解线性方程组。

ENIAC(1945年,美国)

约翰·莫克利(John Mauchly)和约瑟夫·普雷斯珀·艾克特研发,被广泛认为是第一台通用电子数字计算机(现在很多百科已更改定义为世界第二台),为未来计算机的设计提供了许多重要的设计原则,是在借鉴ABC计算器的一些设计基础上,发展的图灵完全的电子计算机,能够重新编程,解决各种计算问题。ENIAC为美国陆军的弹道研究实验室(BRL)所使用,用于计算火炮的火力表。它的计算速度比机电机器提高了一千倍,这是一个里程碑式的飞跃,之前没有任何一台单独的机器达到过这个速度。

冯·诺依曼架构(1945年)

约翰·冯·诺依曼提出的计算机设计架构,首次应用是在ENIAC的后续计算机,如EDVAC(电子离散变量自动计算机)上,至今仍是现代计算机设计的基础。

单机/集群计算力时代

2023年12月23日,在工业和信息化部电子信息司先进计算推进工作组专家咨询委员会指导下,中国信息通信研究院(简称“中国信通院”)发布了《先进计算技术路线图(2023年)》就是从这时开始划分的。

2023年12月中国信通院《技术路线图》

从2006年起,允许用户通过互联网访问和使用远程服务器上的计算资源,实现了计算能力的按需分配,以国外AWS为代表的一代,微软、谷歌、阿里纷纷下场,标志一个新时代的到来,随之诞生的是大数据和AI技术的崛起。

云计算和大数据时代(2006年-)

云计算

指通过互联网远程访问计算资源的能力,包括服务器、存储、数据库、网络、软件、分析等。用户可以按需获取计算资源,而无需直接管理物理服务器。云计算平台,如AWS、Azure、谷歌、阿里,提供了弹性伸缩的计算能力,使得算力可以根据需求动态调整。

大数据

随着数据量的爆炸性增长,如何快速有效地存储、处理和分析这些数据成为一个挑战。大数据技术,如Hadoop和Spark,使我们能够处理和分析PB级别的数据集,发掘数据价值。

超级算力(智算时代)(2020年-)

人工智能计算

AI和机器学习模型,特别是深度学习模型,需要大量的计算资源来训练和推断。这些模型通常在GPU或专门的AI加速器(如Google的TPU)上运行,以提高计算效率。

HPC涉及使用超级计算机和并行处理技术来解决科学、工程或业务上的复杂计算问题。这些系统能够提供巨大的算力,支持天气预测、气候研究、分子建模、物理模拟等领域的高级计算需求。

今天的算力是激活新质生产力的关键。

当我们今天讨论“算力”时,通常指的是涵盖云计算、大数据处理、人工智能计算和高性能计算(HPC)等领域的综合计算能力。这个概念主要强调的是计算速度和数据处理能力,特别是在处理复杂运算和大规模数据集方面的能力。

随着计算机软硬件技术的发展,现在的算力特指计算机的计算能力,是支撑和决定信息化、数字化应用水平的核心因素,也是激活新质生产力、释放数字经济高质量发展新动能的关键要素。

算力单位的进化

早期计算机时代

每秒运算次数

在早期计算机技术中,计算能力通常用每秒能进行的固定或浮点运算次数(Operations Per Second, OPS)来衡量。这个单位可以用来大致描述早期电子计算机的性能。

微处理器和个人计算机时代

每秒百万次运算(MIPS)

这是衡量早期微处理器和个人计算机性能的常用单位,表示每秒可以执行多少百万条指令。

每秒百万次浮点运算(MFLOPS)

随着计算需求的增长,尤其是在科学和工程计算领域,MFLOPS成为了衡量计算能力的一个更为关键的指标。

高性能计算和现代计算时代

每秒十亿次浮点运算(GFLOPS)

随着计算能力的提升,GFLOPS成为衡量中等规模计算系统性能的标准单位。

每秒万亿次浮点运算(TFLOPS)

用于衡量更高级的计算系统,如早期的超级计算机和一些高性能图形处理单元(GPU)。

每秒千万亿次浮点运算(PFLOPS)

当前,世界上最强大的超级计算机的性能已经达到或超过了PFLOPS级别。

每秒百亿亿次浮点运算(EFLOPS)

随着计算技术的进一步进步,一些最先进的超级计算机项目已经在追求达到EFLOPS的计算能力。

我们现在说的多少P的算力,是指这个千万次亿次的计算单位(PFLOPS),当说一个算力中心有“5P”的计算能力时,意味着该中心能够每秒执行5千万亿次浮点运算——以效率比较就是人类手工绘制地图和使用卫星自动绘制全球地图的区别。

算力到底有多惊人

听起来还是很抽象,不好理解这个算力到底有多么庞大惊人。

假设我们用1粒沙子代表1个算力,即1粒沙子每秒可以进行1次浮点计算,比如1+1=2,那么撒哈拉沙漠相当于都是什么规模的算力中心?

撒哈拉沙漠的面积大约是910万平方公里,平均深度为150米(相当于一栋50层楼),是地球上最大的沙漠,取沙粒直径0.5毫米(已经属于粗砂了),空隙率为40%,经GPT简化估算:

要估算撒哈拉沙漠的总算力,我们首先需要估算撒哈拉沙漠中大约有多少粒沙子:

-

首先,撒哈拉沙漠体积为:

9,100,000km2x1,000,000m2/km2x150m= 1.365 x 1015 m3

-

接下来,我们需要估算每立方米中有多少粒沙子:

每粒沙子的体积≈(5x10-4m)3= 1.25x10-10 m3

每立方米中的沙粒数量≈1 m3÷(1.25x10-10 m3)=8x109

-

因此,撒哈拉沙漠的总沙粒数量大约是:

1.365 x1015m3 x8x109 沙粒/m3=1.092 x1025 沙粒

(小编发现Chatgpt不会科学计数法,需要人工校数)

如果每粒沙子代表1FLOPS的算力,1P=1015FLOP,那么撒哈拉沙漠的总算力大约是1.092 x 1025 FLOPS,即1.092x1010P(109.2亿P)。

这真是一个天文数字,之前有自媒体根据Omadia研究报告数据推测英伟达H100人工智能显卡在2023年的出货量为120万块,H100的算力是4P,也就是480万P,两相对比,可以帮助大家更好的理解这个撒哈拉“算力”的庞大。

假设每做一份盒饭相当于完成一次浮点运算。那么,1万PFLOPS相当于每秒钟能做出1x1019份盒饭。

假设地球上为80亿人,每人每天需要3份盒饭,一年所需要的盒饭数量为:

80亿人×3份/人/天×365天=8.76×1012份

因此,按照这个比喻,1万P的算力中心1秒钟做的盒饭,可以支持地球上80亿人吃大约1x1019/8.76×1012=1,141,553年,即114.2万年。

通过这两个通俗易懂的比喻,我们希望能够帮助大家更直观地了解算力的庞大及其在现代科技中的重要性。这种力量,像是无边的海洋,蕴藏着几乎无限的可能性。然而,海洋的广阔并非每个航行者都能驾驭,关键在于如何精准导航,找到最有效的航线。

正如船只需要精确的航海图和熟练的舵手一样,我们在使用这庞大算力的过程中,也需要合理的规划和管理。如何避免资源的浪费,如何确保每一份算力都能发挥其最大的价值,成为了我们必须面对的问题。

在即将到来的《算力分区与算力池化》一文中,我们将深入浅出的讨论智能化分区与池化技术,有效地管理和优化算力资源。这些方法不仅可以帮助我们减少冗余,提高效率,还能在更广泛的领域内发挥出算力的最大潜能。

相关产品介绍

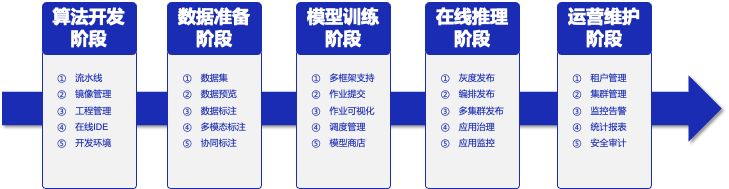

AIOS是博云专为AI应用推出的企业级一站式人工智能操作系统,屏蔽底层异构算力差异,面向大规模分布式计算,在计算、网络、存储、调度等基础能力全面增强,为AI应用提供稳定、高效、极简的底层支撑能力。同时AIOS支持主流的分布式AI深度学习框架,可满足算法、模型、组件的可视化开发,覆盖算法开发、数据管理、模型训练、在线推理的全生命周期。AIOS可以帮助企业和开发者自主构建人工智能业务,助力企业保持行业领先能力。

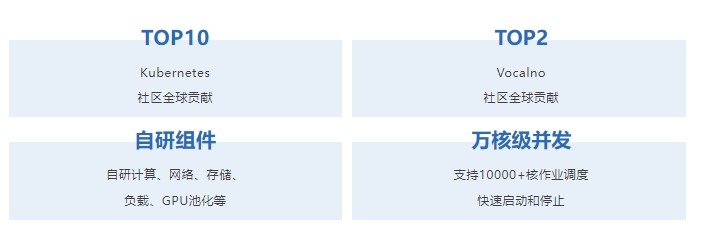

强大的底层掌控能力

AIOS的核心在于其强大的BKE-Turbo算力引擎,支持高达5000个节点的稳定调度,以及异构GPU池化管理,确保了多租户算力的强隔离和全方位监控。

功能特性

覆盖深度学习业务全流程,加快模型从研发到上线速度

深度学习训练任务通常包含多个阶段,从数据处理、算法开发、模型训练、超参调整、模型管理与部署等,AIOS提供全流程支持。

快速部署计算环境并启动训练任务,提高研发效率

深度学习框架和模型众多,依赖各不相同,对开发环境的要求比较复杂, AIOS可以实现资源和工作环境的隔离及快速部署。

支持数据集统一管理,提升数据标注效率

数据集种类众多,数据标注工具不一。AIOS内置多种数据集标注工具,支持人工标注、协同标注、智能标注等多种业务场景,极大提升数据标注效率。

支持多种建模方式,方便算法工程师快速构建复杂模型

支持Jupyter交互式建模,方便算法工程师对代码进行调试;平台内置多种算法组件,支持通过拖拉拽方式实现可视化建模,极大降低建模门槛。

训练过程可视化,掌握训练进度及质量

深度学习模型训练周期较长,训练结束后才发现模型质量问题。借助AIOS,可以实现对训练过程实时监控并可视化训练过程,实时观测损失函数值的日志、训练误差或测试误差等。

动态分配 GPU 资源,充分利用资源,提高资源利用率

支持 GPU 资源细颗粒度调度能力,最低可划分1%资源。同时支持众多国产GPU算力。单一计算集群可以统一管理异构的多种GPU算力。

全面的集群监控管理,实时掌握 CPU/GPU 资源使用情况及运行状态

实时监控集群的使用情况,合理安排训练任务;及时发现运行中的问题,提高集群的可靠性。

方案优势概览